Робот Яндекса строго соблюдает правила указанные в robots.txt

Совсем недавно на блоге небезизвестного Платона Щукина появился материал, касающийся причин попадания страниц, файлов и документов, которые закрыты от индексирующих роботов Яндекса (и не только) в файле robots.txt в результаты поисковой выдачи (то есть они доступны рядовому пользователю поисковой системы). По его словам робот Яндекса строго соблюдает правила указанные в robots.txt, ведь этот файл является для него некой инструкцией, которую нельзя нарушать. Тогда почему возникают такие проблемы, если, скажем, некоторые страницы сайта запрещены к индексации? Причин возникновения данной проблемы может быть несколько.

Чтобы робот Яндекса следовал установленным инструкциям, указанным в файле robots.txt, следует выполнить ряд условий:

- файл robots.txt обязательно должен находиться в корневом каталоге вашего Joomla сайта, то есть он должен быть доступен по адресу ваш_сайт.ru/robots.txt

- при обращении роботом к robots.txt ему должен возвращаться код HTTP 200, тогда все директивы из этого файла будут учтены (в случаях, когда робот получает любой другой код, или файл осуществляет перенаправление, робот не сможет получить его содержимое)

- учитывайте лимит на размер файла, ведь он не должен превышать 32Кб, иначе робот сочтет, что эта инструкция чрезмерно сложная или ошибочная ( в таких случаях робот воспримет её как полностью разрешающую)

- если в вашем файле robots.txt присутствуют правила сразу для нескольких индексирующих роботов, то робот Яндекса выполнит те, которые предназначены именно для него (User-agent: Yandex)

- в случае выявления конфликтующих директив он выберет разрешающее правило, например:

User-agent: Yandex

Allow: /

Disallow: *

Если вы выполните все эти условия, то вы можете быть полностью уверены в том, что Яндекс-робот выполнит заданные вами правила индексирования вашего сайта, а страницы и директории, запрещённые в robots.txt, не будут индексироваться (посещаться) и, соответственно, не попадут в результаты поисковой выдачи.

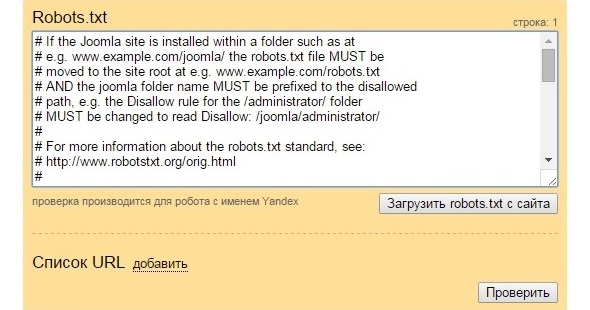

Для проверки корректности настроек файла воспользуйтесь анализатором robots.txt от Яндекса.

Комментарии